见证"芯"路 30年CPU架构发展史(一)

Core时代:四发射成为关键王牌

尽管Yonah开始拥有“Core”的新商标,但真正意义上的Core架构却是从Merom内核开始的,Merom是英特尔反思Pentium 4教训和汲取Pent ium-M营养的翻身之作,它发布于2006年第三季度。Merom终于能够原生支持64位的EM64T架构,但其成就远不止于此。Merom同样出自以色列人之手。

我们再回头来看Me rom,它伟大的设计就是做到了四发射,也就是同时可解码四道指令—而之前的x86处理器只能做到三道。这意味着在一个时钟周期内,Merom已经在指令解码方面直接获得33%的性能增长。如果是RISC处理器,四发射设计并不困难,绝大多数RISC产品都是这么干,这是RISC产品优于CISC的关键点。深层次原因在于RISC指令系统简单,而x86指令系统仍然较为复杂,硬件强行四发射设计,会出现频率难以提升的陷阱。Merom吸收了RISC的营养,英特尔将指令分为20%的热指令与80%的冷指令,并进行深度优化,从而做到四发射和频率提升的均衡。这项成就迄今为止都是英特尔的技术壁垒,AMD的K10架构无论如何改进都无法突围,据说其新一代“推土机”架构,才实现四发射,但也传闻其遭遇频率难升的麻烦。

Merom另一项关键改进就是Macro Fusion(宏指令融合)技术,宏指令融合技术比微操作融合技术的应用更为广泛,如If和Jump指令结合,这项技术进一步增加了执行效率。总之,在一系列提高效率到牙齿的技术环绕下,Merom的每瓦性能高到不可思议的地步,AMD的Athlon X2系列毫无还手之力,只能依靠性价比取胜。

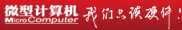

图10 Core微架构融合了英特尔的经验与教训,并获得压倒性的优势。

在这个时代英特尔也放弃台式机、移动不同架构的做法,将两者重新整合在了一起。显然,英特尔被Pentium 4的高热量吓坏了,这次它优先设计低能耗的Merom,然后再衍生出针对台式机市场的“Conroe”,也就是我们俗称的“扣肉”。

Conroe在内部架构上同Merom没有任何区别,功能上也完全一致,只是作为台式机处理器,它在功耗方面的要求更加宽松,这就使得Conroe也可以做到更高的频率—虽然还无法同Pentium 4比肩,但卓越的指令效率,让它终获得惊人的性能,与Pentium 4拉开了很大的差距。

Merom时代的迅驰平台代号为Santa Rosa,该平台包含四大组件,分别是Merom处理器、i965M系列芯片组、i4965AGN无线模块和Intel Turbo Memory模块。这其中有意义的是无线模块,让300Mb/s的802.11n标准取代了低速的802.11g;而糟糕的当属那个叫做“迅盘”的Intel Turbo Memory模块,它本来应该起到加速作用的,但用户普遍发现它其实会让开关机变得缓慢无比,终这个模块没有继续发展,因为兴起的SSD固态硬盘显然是更好选择。

Merom的接替者是45纳米工艺的Penryn,它发布于2007年11月(台式机版与服务器版)和次年的一季度(移动版),Penryn并没有带来太多的新技术特性,SSE4指令集应该算一个,还有一个就是动态加速技术。Penryn的性能提升幅度也比较小,因为这个时候英特尔已经在性能方面遥遥领先于AMD,所以没有太大必要快马加鞭。不过Penryn时代出现了四核心处理器,这主要针对台式机和服务器市场。得益于先进的45纳米High-K工艺,Penryn的功耗水平更低,移动处理器依然停留在25瓦水平,同时由于节能技术更丰富全面,Penryn平台笔记本电脑的电池续航力仍有一定的提升。

第二代Core架构与核芯显卡:兼容并包

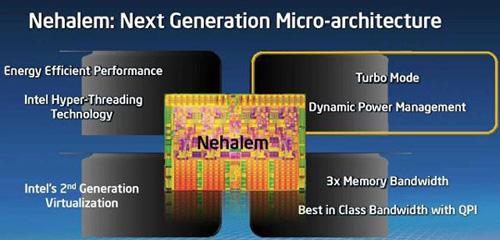

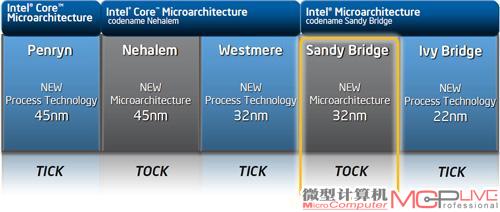

从Penryn开始,英特尔将更新换代的步骤整合为“Tick-Tock”(意指像钟摆一样“滴答”作响的有序步调)工艺与微架构发展战略—Tick指每隔两年的奇数年推出核心面积更小,制作工艺更先进的处理器,即指半导体工艺升级;Tock指每隔两年的偶数年推出新架构的处理器。

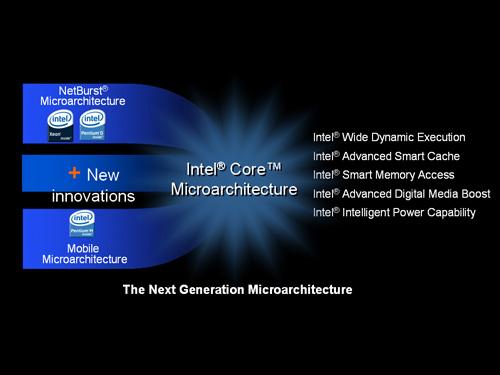

那么时间表到了2008年,新一代架构Nehalem出炉,这是Core2架构的首度重大革新,革新点主要两方面:一是将内存控制器整合于CPU内部,可支持三通道DDR3,这种设计可以有效降低内存系统的延迟,借此进一步提高性能;二是引入高速QPI总线技术,便于多处理器的互联与扩展。AMD有足够的理由指责英特尔在抄袭,因为这不过是2003年K8架构就实现的东西;当然AMD其实也在抄袭RISC阵营的设计。

Nehalem在内部设计方面还有大量的改进,但我们认为这些常规的改进不值一提,前面所说的两个革新才是Nehalem获得性能突破的关键。从Merom时代开始,英特尔就一直在CPU性能上占据压倒性的优势,Nehalem时代同样是如此,不过此时AMD吸纳了ATI的图形技术,在市场上给英特尔的威胁反而加大。

图11 Nehalem整合了内存控制器,引入QPI总线,连接架构类似于AMD平台

在Nehalem时代,“迅驰”商标寿终正寝,英特尔开始强调“酷睿”品牌,这其实是一种倒退,实际上我们也认为并非明智之举。既然不再捆绑式销售,PC厂商有自由的选择了么?NO,PC厂商还是必须选择英特尔的处理器、芯片组和无线网络模块。英特尔认为自己通吃比较好,结果它得罪了几乎整个产业界,不断逼出NVIDIA、ARM等更强硬的竞争对手。

图12 Westmere将CPU芯片与GPU芯片封装在一起,构成一枚混合处理器。

到了2009年,英特尔开始将制造工艺升级到32纳米,这便是Westmere。Westmere实现了六核心设计,拥有高达12MB的三级缓存,不过移动版还是以双核心为主。Westmere大的创举还是将GPU整合在处理器内部。当然,你知道,它提供了够用但不强悍的性能,无论3D或高清视频方面都还马马虎虎,虽然无法同NVIDIA、AMD的GPU技术相提并论,但此举让英特尔进一步蚕食了独立图形市场。

虽然将GPU与CPU整合在一起依然是AMD的主意,这也是AMD并购ATI的主要目的之一,但问题是AMD一直停留在纸面谈论阶段,反而让英特尔抢了先机。虽然Westmere仅仅是将GPU芯片同CPU封装在一起,但从今天来看,英特尔这抢先的一步棋着实对“整合”的趋势起到了重要的推动作用。

CPU与GPU的整合大潮,也让NVIDIA的生存空间被挤压殆尽,NVIDIA先期被迫放弃了芯片组市场,低端显卡市场也不断萎缩,但它以GPU通用计算来反戈一击,同时将 Tegra移动芯片发展得风生水起,接着它与微软结盟,准备以ARM架构的Denver进入PC市场,可以说NVIDIA今后将是英特尔巨大的麻烦。

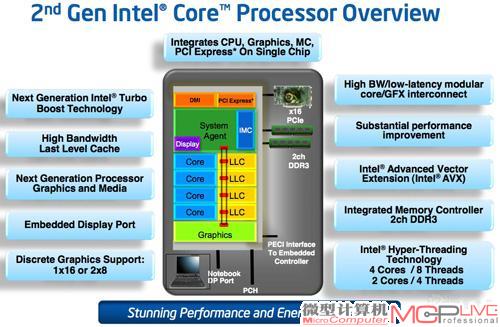

2011年1月,新一代架构Sandy Bridge出炉,这代架构的主要特点则是加入了game instrution AVX(Advanced Vectors Extensions)技术,也就是之前的VSSE。AVX技术将矢量运算的宽度从之前的128bit扩展到256bit。英特尔宣称,使用AVX技术进行矩阵计算的时候将比SSE技术快90%,其重要性堪比1999年 Pentium Ⅲ引入SSE。不过,Sandy Bridge引人注目的地方还是将GPU直接集成于芯片内,做到硬件层面的高度融合,同时CPU、GPU可以共享三级缓存,显著改善了GPU的性能表现。至于GPU本身的架构也得到相当的增强,使得Sandy Bridge的图形性能直逼低端独立显卡。此外,Sandy Bridge中还集成了视频引擎,可以对1080p高清媒体进行硬件解码,这样就不必再消耗CPU资源。内存控制器方面,Sandy Bridge可以支持双通道DDR3-1600。

除了性能的增长外,Sandy Bridge拥有相当多的人性化技术,比如新一代 “Turbo Boost”智能动态加速技术更为有效,CPU、GPU可以分别动态运行,节能效果相当出众。总之,Sandy Bridge是相当值得称道的产品,它不仅在CPU性能方面有10%~30%的提升,GPU性能也接近翻番,该平台的笔记本电脑普遍拥有4~5个小时的续航能力,整体表现极为出众。

然而,尽管新平台如此的出众,英特尔面临的市场竞争压力不仅没有因此变小。作为老对手,AMD在CPU领域的弱势地位一直没有改变,并且性能差距幅度相当可观,但伴随着ATI图

形技术的整合,AMD平台的整体吸引力越来越强——CPU性能过剩已经是共识,高一点或低一点对实际体验影响有限。而图形性能对用户体验影响显著,AMD在这一领域的优势十分显著,它在今年6月份发布Fusion APU,并且提出“异构计算”的理念,籍由GPU来加速高密集度的计算任务,从而获得综合的性能优势。

由于英特尔没有强有力的图形技术,先前开发的Larrabee项目又转向其它并行处理领域,这意味着在异构计算时代它只是一个配角。伴随着OpenCL的确立,我们相信支持异构计算的应用程序将会越来越多,包括多媒体视频编解码、文件压缩、Flash动画、图像处理和音频制作等涉及密集运算量的场合,异构计算将成为标准,无论英特尔拥有多么强大的CPU,都无法同更擅长此道的GPU相对抗,这也是它在未来要面对的严峻局面。

图13“Tick-Tock”的“钟摆”已走到了Sandy Bridge这一步

图14 Sandy Bridge系统的架构示意图

点击阅读《见证“芯”路 30年CPU架构发展史(二) 》。